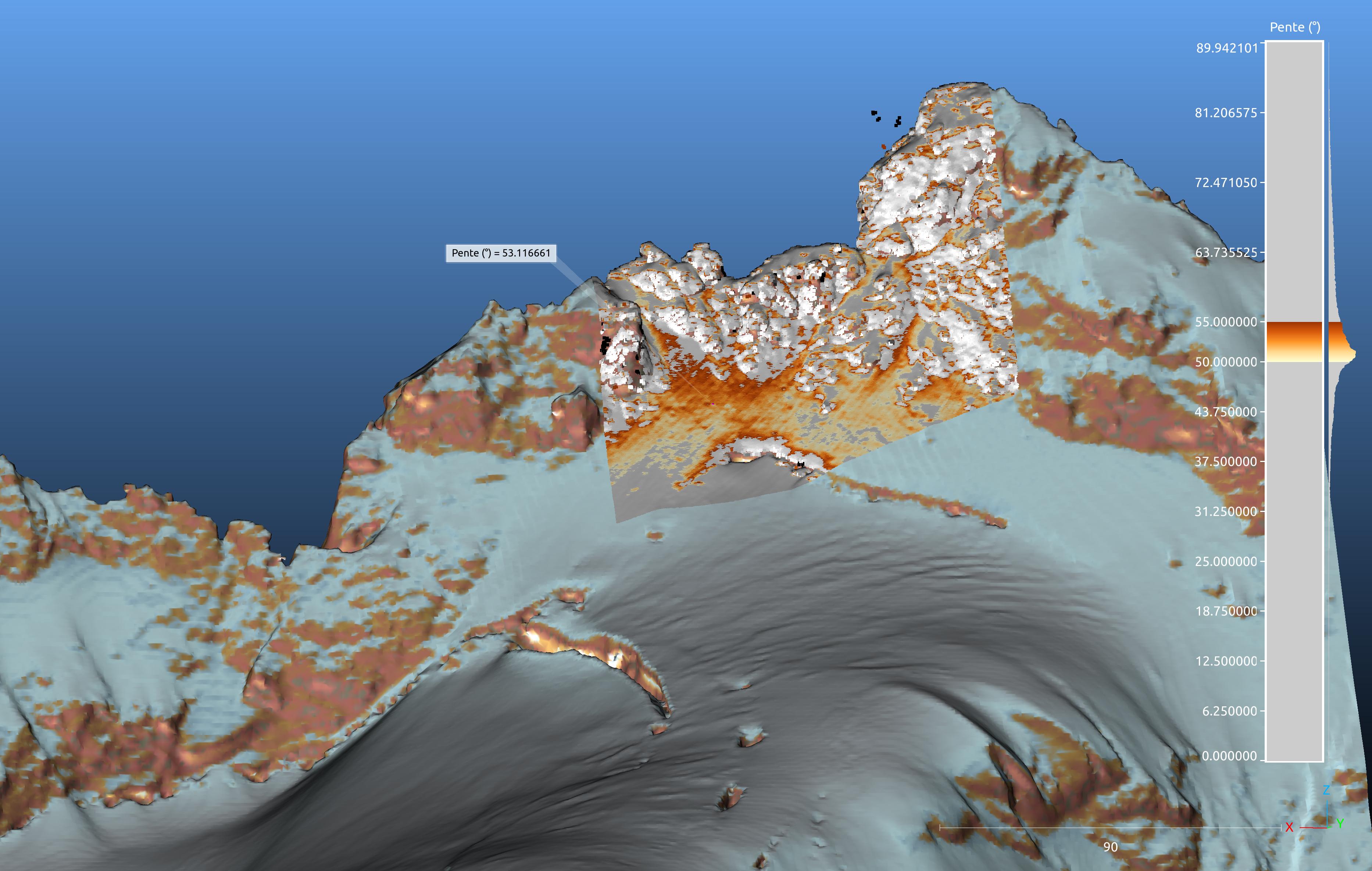

en présence de végétation, chaque rayon envoyé par le lidar percute soit la terre, soit une feuille, en gros. Ensuite, un algorithme groupe tous les points les plus bas et les classe comme étant du « sol ». Ensuite, il reste tous les points plus haut que le sol, on peut en déduire que ce sont des points qui ont touché la végétation. Avec le logiciel de visualisation, on peut ensuite filtrer les points et n’afficher que les points « sol », ou bien afficher tout « sol+végétation ».

À l’IGN, ils ont décidé de sous-catégoriser les points « végétation » en 3 : basse végétation= les point de 0 à 1m du sol, végétation haute = les points au dessus de 5m du sol, et végétation moyenne = entre les deux.

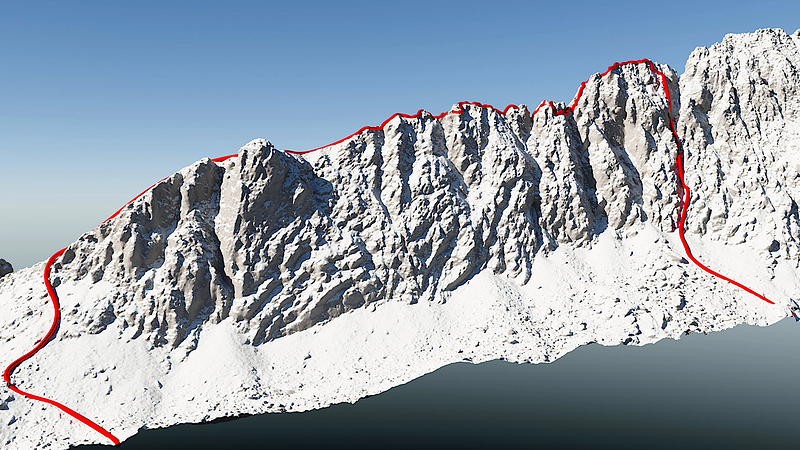

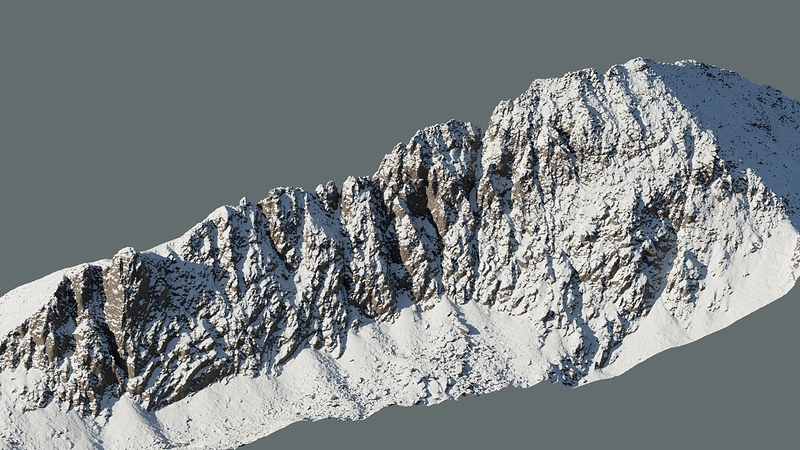

Du coup, dans les zones désertiques, tous les points sont du « sol » car ils sont tous à peu près au même niveau : 100% des rayons dessinent le sol. Dans une zone très boisée, 10% (au pif) des rayons atteignent le sol : il est donc moins bien défini quand même. Mais il est tout à fait possible de voir les fossés, les surfaces des chemins forestiers, les remblais, les terrassements recouverts d’arbres. C’est comme ça, comme le dit @AntoineM que les archéologues découvrent d’anciens vestiges mayas en foret.

D’autres algos de classification déduisent selon les répartition si ça peut être des constructions humaines (toits, murs) ou bien par exemple des ponts.